-

行业资讯

INDUSTRY INFORMATION

【导读】

IT支持团队是企业数字化运行的“隐形地基”,但不少企业的IT支持岗位绩效指标,要么只盯工单数量和响应时间,要么流于形式、难以真正反映业务价值。本文围绕 IT支持岗位绩效指标 的设计,提出一个三层四维的系统框架,并给出互联网、制造、金融三类典型场景的指标模板与案例,聚焦回答:如何设计科学的IT支持岗位绩效指标。适合HR、IT负责人、业务管理者一起对照实践、优化现有考核方案。

很多企业都经历过类似场景:促销大促刚开场,订单却卡在支付页面;新版本上线后,客服热线被用户投诉淹没;工厂夜班,生产线因为一台服务器故障停了整整一夜。

这时,IT支持团队往往成为“第一响应人”,但到了年终考核,他们的绩效指标却常常只有几条简单的描述:处理工单数、响应是否及时、是否按流程记录日志。

从管理视角看,这样的绩效设计有两个明显问题:

一是无法体现IT支持对业务连续性、客户体验和风险防控的真实价值;

二是难以引导团队朝着正确方向优化,比如从“救火”向预防性维护和知识沉淀转变。

德鲁克曾提出,无法衡量就无法管理。放在IT支持场景里,问题就变成了:如何设计科学的IT支持岗位绩效指标,让团队既“跑得快”,又“跑在对的方向上”?

下面的内容,将沿着这样一条路径展开:先看清常见陷阱,再搭建系统框架,最后用若干模板和案例,把方法变成可以拿去用的表格和指标组合。

一、解构痛点:IT支持绩效指标常见陷阱与设计原则

这一部分先给结论:大多数IT支持绩效指标“考而无效”,不是因为指标不够多,而是因为方向错了、结构乱了、数据假了。

要走出困局,需要回到两个问题:出了什么错?哪些设计原则是必须坚守的?

1. 为什么很多IT支持绩效指标考不出效果?

从实践看,IT支持指标失效,大致集中在几类典型陷阱。

(1)与业务战略脱节:只看工单,不看业务

不少企业的IT支持考核表长这样:

- 每月处理工单数量

- 平均响应时间

- 是否按流程填写工单

看似量化充分,实际却与企业核心业务目标几乎没有直接联系。

举个典型场景:企业线上商城在年度促销时,多次出现支付卡顿, IT支持团队忙着“救火”,每次都按时响应、快速处理,工单量和响应时效的指标都很好看。但如果没有指标去衡量“大促期间关键系统的整体可用性”和“重大业务中断次数”,管理层就无法判断IT支持对促销目标的真实保障程度。

结果就是:考核上他们是优秀员工,业务层面却总觉得系统“不靠谱”。

(2)片面追求“快”,忽视解决质量与预防能力

另一个常见失衡,是绩效表里几乎全部是效率指标:

- 首次响应时间

- 平均解决时间

- 每人每日处理工单数

这类指标当然重要,但如果全靠它们来评分,很容易诱导出两个行为:

- 为了缩短平均处理时间,把复杂问题拆分、转派甚至“暂时关闭”,导致用户多次报修;

- 在根因分析和知识沉淀上“能省就省”,缺乏预防性维护的动力。

从长期视角看,这类指标会让团队习惯于快速救火,而不是减少火灾。

(3)组织适配不足:所有IT支持用一张表

很多公司只有一版通用的“IT支持岗位绩效表”,无论是:

- 负责总部办公网络支持的IT工程师,

- 深入车间负责生产系统运维的现场工程师,

- 还是金融机构中负责核心业务系统支持的专员,

都套用完全相同的指标。

这会带来两个明显问题:

- 对关键岗位而言,指标太“轻”,对系统稳定、合规风险等重要要素缺乏约束;

- 对基础支持岗位而言,指标太“重”,很多要求他们根本无权也难以影响。

结果是:一张考核表既无法体现差异化贡献,也难以真正指导日常工作。

(4)数据不可得或不可靠:写在表里,做不到系统里

还有一种隐蔽的风险,是指标看上去专业、合理,但数据采集严重依赖人工手工统计:

- 用户满意度要靠线下回访或纸质表格;

- 故障恢复时间要靠工程师事后回忆;

- 知识库更新次数要靠自报。

这类指标一旦进入年度考核,极易出现几个后果:

- 数据失真,难以被一线员工信服;

- 记录成本太高,团队疲于应付统计,而不是改进服务;

- HR和管理层很难基于数据做趋势分析和优化。

简单说,就是指标写在纸上挺好,落到系统里却“行不通”。

表格:常见IT支持绩效指标设计问题一览

| 典型问题 | 具体表现 | 带来的后果 |

|---|---|---|

| 战略脱节 | 只统计工单量、响应时长 | 无法体现对业务目标的支撑程度 |

| 偏重效率轻质量 | 只看处理速度,不看一次解决率和根因分析 | 容易“快而不良”,重复故障频发 |

| 忽略岗位差异 | 用一套指标覆盖所有IT支持岗位 | 对高风险岗位约束不足,对基层岗位要求过高 |

| 数据不可得或不可靠 | 严重依赖人工统计 | 统计负担重、数据失真、难以自动分析 |

2. 从陷阱中提炼出的设计原则:SMART-Plus

在大量项目中,我们发现,只要做到下面这几个原则,大部分指标设计问题都会自然消失。可以把它概括为一个扩展版的 SMART-Plus 原则。

(1)S(Specific):与具体业务场景强相关

- 指标不能只写“系统稳定”,而要聚焦具体关键系统和关键时段,例如:

- 大促期间电商交易系统可用性

- 夜班生产线控制系统无计划停机时长

- 每个指标背后,都要能说清楚:它对应的是哪类业务风险或收益。

(2)M(Measurable):可量化且可获取

- 所有指标都应明确数据来源,是来自ITSM工单系统、监控平台,还是客户满意度调研工具。

- 对于暂时难以量化的内容,可以先通过分级评分、行为描述等半量化方式过渡,但要规划未来的数字化采集路径。

(3)A(Achievable):在现有资源和权限内可实现

- 衡量一个岗位时,要确认他是否拥有改进该指标的资源和权限。

- 例如,要求一线支持工程师对“整体IT预算控制率”负全责,显然不现实;但让他们对“自管设备故障复现率”负责,则更可行。

(4)R(Relevant):与IT与业务战略高度相关

- 指标不应仅仅是IT部门内部视角,而要能回答一个问题:

“如果这个指标提高了,业务会感知到什么不同?” - 比如,提升一次解决率,会减少业务团队多次报修的时间损耗;提升知识库复用率,会加快新人的上手速度。

(5)T(Time-bound):有明确考察周期与趋势观测

- 不是所有指标都适合按月考核,有些更适合作为季度或年度趋势观察项。

- 例如,重大故障次数适合按季度/年度看趋势,而响应时间则适合按月甚至按周进行跟踪。

(6)Plus1:战略对齐性

- 每一条IT支持绩效指标,都要能追溯到上一级的部门目标、再往上到企业战略目标。

- 未能对齐的指标,即便设计得再精巧,也可能成为“跑偏的努力”。

(7)Plus2:行为引导性

- 指标不仅是评价工具,更是行为导向。

- 一个好的指标,应能清晰地告诉IT支持员工:

- 我应该更重视哪些类型的需求?

- 我需要在哪些环节做主动预防?

- 我与业务、与其他IT团队之间应该怎样协作?

用一句话概括本节结论:

指标的价值,不在于数量和复杂度,而在于是否真正连接了业务目标、工作行为和可获取的数据。

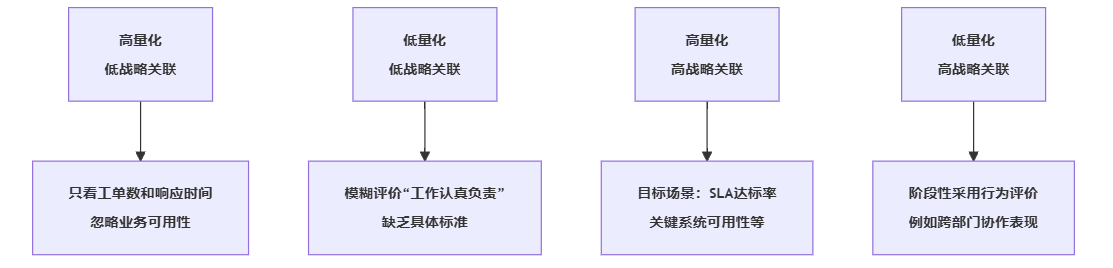

图示:IT支持指标设计常见陷阱象限图(示意)

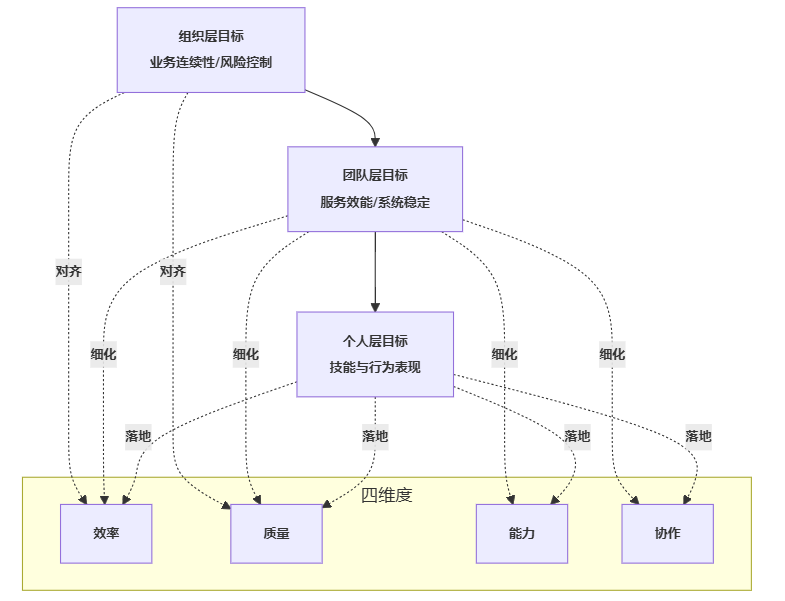

二、搭建框架:三层四维的IT支持绩效指标体系

在明确了原则之后,需要一个可复用的整体结构,避免每次设计都从零开始。

我们在多家企业实践中,逐步沉淀出一个三层四维框架,用来系统设计 IT支持岗位绩效指标。

核心思路是:纵向按组织、团队、个人三层解码目标,横向按效率、质量、能力、协作四维搭建指标体系。

1. 三个层级:组织层、团队层、个人层

(1)组织层:IT与业务战略对齐

组织层的IT支持绩效,更接近“IT运营健康度”。典型关注点包括:

- 关键业务系统全年可用性目标

- 重大业务中断事件次数

- 信息安全事件数量与等级

- IT服务整体满意度

这些指标通常用于考察IT部门整体表现,与财务、运营等核心业务KPI有直接对应关系。

(2)团队层:服务效能与协作成果

团队层关心的是某一支持团队(如应用支持组、网络运维组、生产系统支持组)的整体输出:

- 故障平均修复时间(MTTR)

- 首次响应时间

- 一次解决率

- 跨团队协同问题解决率

- 知识库更新与复用情况

这一层既对上支撑组织层目标,又对下为个人层指标提供分解基础。

(3)个人层:技能、行为与任务结果

个人层的指标,重点是把上层目标落到可执行的行为上:

- 个人处理工单的响应与解决表现(在合理范围内使用效率指标)

- 参与根因分析、提出改进建议的频次与质量

- 完成规定培训、通过技能认证的情况

- 在团队协作、知识分享中的实际贡献

关键在于:个人层不应该简单复制团队层的数字,而是要体现“个人能直接影响的那一部分”。

2. 四个维度:效率、质量、能力、协作

在每个层级中,都可以按四个维度来梳理和筛选指标。

(1)效率维度:做事的速度与成本

- 平均修复时间(MTTR)

- 首次响应时间

- 工单处理时效达标率

- 预防性维护计划完成率

- 自动化运维覆盖率(如脚本化处理占比)

效率指标帮助团队识别流程瓶颈,也为人力和资源优化提供依据。

(2)质量维度:做事的效果与稳定性

- 关键系统可用性

- 一次解决率

- 变更成功率

- 用户满意度(CSAT或NPS类指标)

- 故障重复发生率

质量维度防止团队为了追求速度而牺牲可靠性,有助于推动从“问题驱动”转向“质量驱动”。

(3)能力维度:支撑持续改进的专业基础

- 核心岗位必备认证获取率

- 参加专业培训并通过评估的比例

- 知识库贡献条目数及被引用次数

- 高危操作零失误记录

- 对新技术、新工具的学习与应用情况

这些指标与组织的IT能力成熟度高度相关,也为人才发展和梯队建设提供数据支撑。

(4)协作维度:跨界工作与团队合力

- 跨部门问题协同解决率

- 业务部门满意度(尤其是关键接口人)

- 在项目团队中的协作评价(可结合360度反馈)

- 参与跨团队改进项目的次数和成效

- 文档标准化与共享情况

IT支持工作非常依赖协作,忽视这一维度,很容易形成“各自为战”的局面。

3. 指标库模板:三层四维一览

下面给出一个简化版指标库模板,展示三层四维在IT支持岗位上的组合方式。

表格:IT支持岗位四维指标库模板(示例)

| 层级 | 维度 | 指标名称 | 核心定义说明 | 典型数据来源 |

|---|---|---|---|---|

| 组织层 | 效率 | 关键系统平均恢复时间 | 关键业务系统从故障到恢复的平均时长 | 监控系统、事件管理系统 |

| 组织层 | 质量 | 关键系统年度可用性 | 一年中系统正常可用时间占比 | 监控系统、SLA报表 |

| 组织层 | 能力 | 重大故障根因分析完成率 | 重大故障完成根因分析和改进方案的比例 | 事件复盘记录 |

| 组织层 | 协作 | 业务部门整体满意度 | 关键业务条线对IT服务的综合打分 | 调研工具、问卷系统 |

| 团队层 | 效率 | 本团队工单MTTR | 团队所负责工单从受理到解决的平均时长 | ITSM工单系统 |

| 团队层 | 质量 | 一次解决率 | 无需二次报修的解决比例 | ITSM工单系统 |

| 团队层 | 能力 | 核心技能覆盖率 | 团队成员获得关键技术认证的覆盖比例 | HR系统、LMS学习平台 |

| 团队层 | 协作 | 跨团队协同问题解决率 | 需要其他团队配合的问题解决成功比率 | 工单系统、项目记录 |

| 个人层 | 效率 | 个人工单响应达标率 | 个人在规定时间内响应工单的比例 | ITSM工单系统 |

| 个人层 | 质量 | 个人负责工单好评率 | 用户给出的满意或以上评价比例 | 满意度调查、回访记录 |

| 个人层 | 能力 | 知识库贡献与复用情况 | 本人提交知识条目数量及被引用次数 | 知识库系统 |

| 个人层 | 协作 | 跨部门协作评价 | 业务端及团队成员对其协作表现的评价 | 360反馈、问卷 |

在实际实施中,可以从这个“指标库”中选择与自身业务最相关的若干条,再结合权重进行组装。

4. 三层四维关系框架图(示意)

可以看出,三层与四维并不是独立存在,而是相互交叉:上层决定方向,下层负责实现;效率和质量是结果,能力和协作是前提。

5. 指标权重与动态调整:让体系“活起来”

很多企业在指标设置时,只做了静态分配,比如效率40%、质量30%、能力20%、协作10%。

从实践看,更可取的做法是:权重要与业务阶段、关键项目进程同步调整。

举例:

- 在系统上线初期,质量与风险控制权重可适当提高,效率指标的容忍度则略放宽;

- 在业务高峰期(如电商大促、财年结算),效率与业务连续性相关指标权重适当提升;

- 在稳定运行阶段,则可以拉高能力和协作维度的比重,促使团队投入更多时间在优化与预防性工作上。

这类调整不宜频繁,但每年至少要结合战略规划和重大项目进行一次校准。

三、模板与案例:三类典型场景的IT支持绩效指标组合

框架有了,落到不同企业场景,还需要可直接参考的组合模板。

下面选取三类典型场景,分别给出指标组合思路和简要案例。

1. 互联网企业:高并发与敏捷响应场景

(1)场景特征

- 业务极度依赖线上系统,服务中断直接损失订单和用户;

- 业务峰谷明显,大促、活动期间压力剧增;

- 需求迭代快,系统版本更新频繁,变更风险高。

在这种环境下,IT支持岗位往往被要求做到“快速响应、高可用、可扩展”,指标设计也应围绕这些关键词展开。

(2)指标组合模板(互联网场景)

| 层级 | 维度 | 指标名称 | 设计要点说明 |

|---|---|---|---|

| 组织层 | 效率 | 大促期间关键系统MTTR | 只统计大促定义时间窗内的关键系统恢复时长 |

| 组织层 | 质量 | 大促期间系统可用性 | 以交易核心链路为口径,监控并统计可用性 |

| 团队层 | 效率 | 高优先级工单响应时间 | 对P1/P2级事件设定严格响应时限并跟踪达标率 |

| 团队层 | 质量 | 一次解决率 | 聚焦高优先级工单的一次解决表现 |

| 团队层 | 能力 | 自动化脚本处理占比 | 日常运维中通过脚本自动完成的操作比例 |

| 团队层 | 协作 | 与研发的联调问题解决率 | 涉及开发团队的问题解决情况及平均解决时长 |

| 个人层 | 效率 | 个人值班响应达标率 | 值班期间对告警和工单响应的达标情况 |

| 个人层 | 质量 | 个人负责变更的成功率 | 变更引起严重故障的事件数需为零 |

| 个人层 | 能力 | 新技术工具掌握情况 | 结合培训记录与实践项目评估,如容器、云平台等 |

| 个人层 | 协作 | 业务侧接口人满意度 | 定期由产品、运营等接口人对其支持体验进行打分 |

(3)简要案例:某电商平台的运维指标升级实践

某电商平台早期的IT支持考核,几乎只看工单数量与处理时长。大促期间,即便团队忙得不可开交,指标上看依然“表现优异”,但业务部门抱怨不断:

- 大促期间某些页面加载缓慢,却因为没有彻底宕机而未被视为重大事件;

- 许多问题虽然被快速处理,但一天之内反复出现。

在与HR、业务负责人共同梳理后,他们按照三层四维框架,做了几项关键调整:

- 把“大促期间核心交易链路可用性”上升到组织层指标,由IT负责人对其负责;

- 提高“一次解决率”和“自动化脚本覆盖率”的权重,引导团队从应急处理转向稳定性建设;

- 在个人层引入“业务接口人满意度”,鼓励工程师主动了解活动节奏与需求。

一年后,大促期间的系统整体表现更加稳定,业务部门对IT服务的评价明显提升,IT团队也拿到了更有说服力的绩效结果。

2. 制造企业:生产系统稳定性场景

(1)场景特征

- IT支持与OT(操作技术)深度交织,生产线停机成本高昂;

- 夜班、节假日支持需求大,现场响应要求高;

- 系统更新节奏相对较慢,但稳定性、安全性要求极高。

在这样的环境中,IT支持绩效指标应更多关注生产系统的可用性和预防性维护成效。

(2)指标组合模板(制造场景)

| 层级 | 维度 | 指标名称 | 设计要点说明 |

|---|---|---|---|

| 组织层 | 效率 | 生产线计划停机与实际偏差 | 对比计划检修停机时间与实际停机情况 |

| 组织层 | 质量 | 关键生产系统年度无计划停机时长 | 统计因系统或网络故障导致的非计划停机时间 |

| 组织层 | 能力 | 重大设备故障根因闭环率 | 完成根因分析并落实预防措施的故障比例 |

| 组织层 | 协作 | 生产与IT联合满意度 | 由生产主管和IT主管共同评价联合保障效果 |

| 团队层 | 效率 | 现场故障平均到场时间 | 报修到工程师到达现场的平均时长 |

| 团队层 | 质量 | 生产班次中的系统稳定班次比例 | 一个班次内无系统中断或严重性能问题的班次数比 |

| 团队层 | 能力 | 生产系统专项培训覆盖率 | 运维团队完成生产系统专门培训并通过考核的比例 |

| 团队层 | 协作 | 与设备维护团队协同效率 | 需要设备和IT共同处理的问题解决时间与满意度 |

| 个人层 | 效率 | 指定产线支持响应达标率 | 针对负责产线的个人响应达标情况 |

| 个人层 | 质量 | 个人负责产线的故障复现率 | 同类故障在其负责产线的重复发生情况 |

| 个人层 | 能力 | 安全操作规范遵守情况 | 是否按规定执行变更记录、数据备份、安全检查 |

| 个人层 | 协作 | 生产班组反馈评价 | 由班组长等对支持工程师日常配合情况进行定期评价 |

(3)简要案例:某制造企业的线下场景优化

某制造企业的IT部门,既要维护ERP、MES等系统,也要支持现场工控设备。原本的绩效考核表几乎完全复制总部标准,结果出现三大问题:

- 现场工程师认为很多指标和自己工作无关,积极性不高;

- 生产班组认为IT部门“不理解工厂节奏”,支持不到位;

- IT负责人也难以用指标向上解释生产线停机问题。

在重新设计绩效指标时,企业重点做了三件事:

- 把“生产班次中的系统稳定班次比例”作为团队核心指标,并细分白班、夜班;

- 在个人层引入“生产班组反馈评价”,将现场协作体验纳入绩效;

- 用简单的信息系统记录每次现场故障的到场时间和解决时间,减少纸面统计。

调整后,IT和生产团队之间的沟通明显顺畅,现场工程师也更愿意在班前会中主动提醒潜在风险,系统稳定性有了实实在在的提升。

3. 金融机构:合规与风险控制场景

(1)场景特征

- 信息系统与监管合规高度绑定;

- 对数据安全、业务连续性、审计追踪有严格要求;

- 对外服务中断不仅有经济损失,还有声誉与监管风险。

在这种环境下,IT支持绩效指标必须兼顾服务效率和合规性。

(2)指标组合模板(金融场景)

| 层级 | 维度 | 指标名称 | 设计要点说明 |

|---|---|---|---|

| 组织层 | 效率 | 关键业务系统服务时间内可用性 | 按监管与内部标准设定可用性目标 |

| 组织层 | 质量 | 重大事件报告与处置合规率 | 严重故障按规定时限完成报告和处置的比例 |

| 组织层 | 能力 | 灾备演练完成率与问题整改率 | 包括年度灾备演练完成情况和演练后问题整改到位情况 |

| 组织层 | 协作 | 监管沟通与内外审计通过情况 | 侧重整体合规表现 |

| 团队层 | 效率 | 重要故障上报与升级时效 | 对关键级别事件的上报和升级是否满足规定时限 |

| 团队层 | 质量 | 变更实施后对业务的影响事件数 | 因变更导致影响业务的可记录事件数量 |

| 团队层 | 能力 | 合规制度学习及考核通过率 | 团队成员对相关制度的学习与测评情况 |

| 团队层 | 协作 | 与风险、合规部门协同评价 | 由风险和合规部门对 IT 支持团队的协同配合进行打分 |

| 个人层 | 效率 | 个人处理合规相关工单时效 | 例如权限开通、权限回收等敏感操作的响应与处理时效 |

| 个人层 | 质量 | 零重大合规操作失误 | 特定岗位必须实现无严重级别操作失误 |

| 个人层 | 能力 | 通过安全与合规专项认证 | 包括内部和外部的相关认证 |

| 个人层 | 协作 | 在合规项目中的参与与反馈情况 | 是否积极参与合规性改造项目,是否能提出建设性建议 |

(3)简要案例:某银行的合规导向指标重塑

某银行的信息技术部门在一次内部审计后发现,虽然整体系统可用性尚可,但合规管理存在薄弱环节,如变更记录不够完备、部分重要故障上报不够及时。

在复盘中,他们意识到一个问题:原来的IT支持绩效指标几乎看不到“合规”二字,大部分是运营效率和用户满意度。

于是,银行重新梳理了指标结构:

- 在组织层增加“重大事件报告与处置合规率”“灾备演练完成率与问题整改率”;

- 在团队层及个人层明确“零重大合规操作失误”作为硬性要求,对敏感岗位单独设定;

- 把合规制度学习和认证通过情况纳入能力维度考核,并与晋升挂钩。

调整之后,新一轮审计中,该部门在合规指标上的表现明显改善,监管沟通也顺畅了许多。

4. 三类场景模板对比:重点各不相同

表格:三类场景IT支持绩效指标组合对比

| 维度 | 互联网企业重点 | 制造企业重点 | 金融机构重点 |

|---|---|---|---|

| 效率 | 高并发场景下的快速响应和恢复速度 | 现场到场时间、生产班次保障效率 | 关键故障上报与处置的时效 |

| 质量 | 大促期间核心业务链路可用性、一致体验 | 生产系统无计划停机时长、稳定班次比例 | 合规报告、变更影响事件数、系统可用性 |

| 能力 | 自动化运维、云平台等新技术掌握与应用 | 生产系统与工控设备相关技能与安全操作能力 | 合规制度、安全规范的掌握与认证 |

| 协作 | 与研发、产品、运营的快速协同 | 与生产班组、设备维护团队的紧密配合 | 与风险、合规、审计等部门的协同表现 |

可以看出,框架是一致的,但侧重因行业而异。这也是文章开头强调的:不要试图用一张表覆盖所有IT支持场景。

5. 指标优化的一般实施路径(流程示意)

在三个案例的背后,实施路径大体相似,可以抽象为如下步骤。

在落地过程中,有两点尤为关键:

- 不要一开始就追求“覆盖全部岗位、所有系统”,而是选择1至2个关键场景先做试点,积累经验;

- 同步改造数据采集方式,尽量减少人工统计,优先依靠ITSM系统、监控平台、HR系统等自动化数据源。

结语

回到开头的问题:如何设计科学的IT支持岗位绩效指标?

从上文的分析和案例中,可以提炼出几条对HR和IT管理者较为实用的结论。

第一,先想清楚“IT支持到底在为业务守护什么”。

- 互联网企业更多守护的是高并发下的用户体验与交易连续性;

- 制造企业更多守护的是生产线不停机和工艺稳定;

- 金融机构则在守护系统安全、合规与客户信任。

指标必须紧紧围绕这些关键价值展开,而不是停留在“处理多少工单、响应多快”的层面。

第二,用三层四维框架把零散指标串成体系。

- 组织层对齐战略,团队层承接服务效能,个人层落到技能和行为;

- 在每一层中,兼顾效率、质量、能力、协作四个维度,避免单一追求速度或单一看满意度。

第三,让指标“活起来”,而不是一年一修的静态表格。

- 按业务节奏调整不同维度的权重;

- 通过数字化工具自动采集数据,定期回顾指标是否还能反映当前重点;

- 在试点基础上,小步快跑地修补与优化,而不是一次性大改。

如果要给正在着手优化 IT支持岗位绩效指标 的团队一个实操建议,可按下面的顺序展开:

- 选一个对业务最关键的系统(例如线上交易、核心生产线、重要业务系统),画出其关键业务链路;

- 用三层四维框架,从“业务损失是什么”往回推,列出5至10条最关键的指标;

- 对照现有数据系统,确认这些指标是否可自动采集,必要时先用简单表单或看板过渡;

- 运行一到两个考核周期,邀请业务、HR、IT团队共同复盘:哪些指标有效引导了行为,哪些需要替换或调整权重;

- 在这个基础上,再逐步推广到更多系统和岗位。

科学的 IT支持岗位绩效指标,不只是年终打分的工具,它更像是一张“业务守护地图”:

- 标出哪些地方必须最稳定;

- 哪些环节可以更敏捷;

- 哪些能力需要提前补齐。

当IT支持团队和业务、HR都能在这张地图上找到自己的位置时,绩效管理才真正开始发挥它应有的作用。