-

行业资讯

INDUSTRY INFORMATION

【导读】

很多HR负责人都会问:大中型企业适合使用什么自评互评系统,既要支持几千人的360度反馈,又不能成为昂贵而鸡肋的IT项目。我们的观点是,与其纠结买哪一个产品,不如先厘清:什么样的自评互评系统,才算对大中型企业真正经济实用。本文从自评互评系统的能力矩阵出发,拆解经济性与实用性的关键要素,梳理市场上主流的若干类系统类型与适配场景,并给出实施策略与风险预警,帮助企业在预算可控的前提下,搭建可靠的绩效反馈基础设施。

很多大中型企业的HR,都经历过类似场景:绩效季一到,表单在邮件、Excel和各类系统之间来回穿梭,自评互评流程要么非常复杂、员工抵触情绪明显,要么沦为全员优秀的走过场。管理层一再强调要“用数据说话”“做好人才盘点”,但真正能沉淀下来、支持决策的,却只是一串分数和几个模糊标签。

不少企业因此萌生“换一个自评互评系统就能解决问题”的期待。然而在选型时,又会很快被各种功能清单、技术名词和报价迷惑:有的系统功能极其丰富,但实施周期长、费用高,对当下需求而言明显超配;有的价格亲民,上手容易,却和现有HR系统、业务系统严重割裂,形成新的数据孤岛。

在和多家大中型企业HR团队交流中发现,那句看似简单的问题——“大中型企业适合使用什么自评互评系统?”——背后真正考验的,是企业对自身管理诉求的清晰程度,以及对“经济实用”四个字的再定义。下面从能力矩阵、系统类型、落地策略与风险四个维度,尝试给出更系统的回答。

一、如何定义“经济实用”的自评互评系统:核心能力矩阵

本模块的核心结论是:对大中型企业而言,“经济实用”的自评互评系统绝不是“便宜+功能多”的简单叠加,而是“基础能力完备性 × 总拥有成本(TCO)优化 × 可持续扩展性”的综合结果。 如果只盯着采购价,很容易掉进“看上去不贵,用起来很贵”的陷阱。

1. 基础能力:哪些功能属于“非妥协项”

在过往的案例中观察到,很多选型项目失败,一个根源在于:把好看的功能当成刚需,把看起来很基础的能力当成可有可无。面向大中型企业,以下能力基本属于不可妥协的底线:

360度多源评估能力

- 支持自评、上级评、同级评、下级评,必要时还可引入客户/项目干系人评价;

- 评价对象和评价人关系可配置(例如项目型组织、矩阵型组织)。

如果系统在评估关系的配置上非常僵硬,规模一大,必然导致大量线下补课。

- 多终端、移动端友好

- 支持PC端和移动端(App或企业微信/钉钉等)顺畅使用;

- 移动端表单和问卷在复杂逻辑下仍然易用。

对上千甚至上万员工的组织,参与率本身就是一项硬指标,移动端体验往往比某些高级分析功能更决定项目成败。

- 实时数据看板与关键指标可视化

- HR与业务经理可实时查看流程进度、填报完成率、打分分布等;

- 关键岗位、关键人群的评价概览可一键生成。

这关系到HR的掌控感:项目是否在轨、哪里出现阻塞,不需要靠催促邮件和Excel汇总来感知。

- 权限分级与访问控制

- 支持按角色(HRBP、直属经理、高管)和层级配置数据可见范围;

- 匿名/实名评价在技术上可灵活切换或组合。

如果在数据权限上粗线条处理,一旦涉及争议和合规审计,风险极高。

2. TCO(总拥有成本):不仅是采购价,更是全周期成本

很多预算评审会上,经常会把重点放在首年费用上,而忽略了实施+运维+迭代这三块长期成本。我们更建议用TCO视角去看自评互评系统的经济性,关注三个杠杆:

(1)低代码/配置化程度

- 模板、问卷、评分规则、流程节点,能否通过配置完成,而不是每改一次就要技术开发?

- 对HR团队来说,每一次绩效制度调整、KPI变更、问卷迭代,都是对系统的适应性测试。

配置化不足,后续就会形成持续的外包或开发成本。

(2)部署与扩容模式

- SaaS模式在大多数大中型企业里,已经成为主流选择之一。其优势在于:

- 不必自建基础设施;

- 可按实际使用规模和模块付费;

- 扩容弹性较好。

- 对安全要求、更高定制要求的企业,也会考虑私有化或混合部署。此时就要评估:

- 硬件成本;

- 运维人力成本;

- 升级和支持成本。

(3)自动化能力降低人工参与度

- 自动催办通知、提醒;

- 自动生成标准报告、组织对比分析;

- 自动同步组织架构、人员数据。

这些能力直接影响每一轮评估的人工投入。如果每次绩效季都要HR加班导表格、追进度,即便系统采购价不高,长期TCO依然偏高。

3. 扩展性:系统寿命取决于是否能“跟着组织一起长大”

很多企业在选型时,只考虑了“今年怎么用”,忽略了两三年后组织结构、业务模式、管理理念的变化。可持续扩展性是大中型企业判断系统是否值得上的关键门槛,包括:

- API与数据生态能力

- 能否通过开放接口与现有HR系统(人事、薪酬、考勤)、OA、项目管理系统集成?

- 评估结果能否导入BI工具,或反哺到人才盘点、继任计划模块?

- 评估模型与算法的可迭代性

- 是否支持自定义维度、权重、评分方法?

- 是否允许按组织成熟度,逐步引入更复杂的模型(如胜任力模型、9宫格等)?

- AI模块的按需加载

- 文本评价的情绪分析、关键词提取等,是否作为可选模块,而非一次性打包强制购买?

- 将来企业想从“年度评估”升级为“持续反馈”,系统架构是否能承载?

二、从“买哪款”到“选哪类”:四类系统与适配场景

本模块的核心观点是:大中型企业选自评互评系统,不存在一个对所有企业都最优的单一产品,只有更契合当前阶段与IT环境的系统类型。与其纠结“到底哪一款最好”,不如先判断自己适合哪一类。

1. 轻量级SaaS评估工具:数字化起步阶段的快刀型方案

许多刚从纸质表单、Excel走向系统化的企业,首要诉求很简单:“先把自评互评流程系统化、跑通,不要再靠人海战术。” 这类企业往往适合轻量级SaaS工具。

特点与优势:

- 上线快,配置简单,通常通过在线配置即可发起一次完整的评估轮次;

- 功能聚焦在问卷设计、流程配置、结果汇总和基本报表;

- 费用结构清晰,多按人数或按项目收费,便于预算管理。

典型适用场景:

- 组织规模在数百至数千人之间,尚未建立完善HR信息系统;

- HR团队人手有限,需要工具减轻流程组织的压力;

- 希望在1–2个绩效周期内快速验证“自评互评+绩效面谈”的管理闭环。

风险与局限:

- 与其他系统的集成能力往往有限,组织架构、人员变动需要人工导入;

- 自定义分析和数据下钻能力较弱;

- 随着企业进入“人才盘点”“继任管理”等更高阶应用,可能需要再进行一次升级选型。

对比示意表:

| 维度 | 轻量级SaaS评估工具 | 对大中型企业的意义 |

|---|---|---|

| 上线速度 | 快 | 快速试错,检验绩效文化接受度 |

| 初始投入 | 低 | 适合预算有限、先练手的企业 |

| 定制能力 | 中等 | 满足常见需求,复杂场景需迁就流程 |

| 集成能力 | 较弱 | 以单点工具形式存在,数据孤岛风险 |

| 适用阶段 | 数字化初期 | 用于建立最基本的自评互评习惯 |

2. HR套件内置评估模块:已有HR系统企业的“顺势型”选择

不少大中型企业已经部署了人力资源管理系统(HRM/HCM),其中往往自带绩效管理或评估模块。这类套件内置自评互评模块,对很多企业来说,是成本收益比较均衡的选择。

优势:

- 人员、组织、岗位、薪酬数据与评估结果天然打通;

- 统一账号、统一权限管理,减少多系统登录和维护成本;

- 与人才盘点、培训发展等模块的贯通较为顺畅。

劣势与注意点:

- 在自评互评这一细分场景的功能深度,可能不如专业评估工具:

- 评价问卷设计的灵活度有限;

- 报表和可视化能力偏标准化;

- 智能分析和文本挖掘等功能未必完善。

- 迭代速度通常受制于整套HR系统的版本节奏,不能根据评估项目节奏小步快跑。

适用前提:

- 企业已经有相对稳定的绩效管理流程,主要需求是系统化与整合,而非从0设计新评估方法;

- IT与HR都希望减少系统数量,降低整体运维复杂度;

- 可以接受在某些细节功能上照顾大局,而非追求某个模块的极致体验。

建议:

如果企业已经有成熟的HR系统,优先值得评估的是:能否通过模块优化与适度定制,把内置评估模块用好。只有在确认成本过高、灵活度远不能满足需求时,再考虑额外上一个独立评估系统。

3. 低代码/平台型解决方案:高度定制化企业的工坊型工具

对一些业务高度多元、组织结构复杂、管理诉求强烈的集团型企业而言,通用工具往往无法完全适配。这类企业更倾向于选择低代码/平台型解决方案,在技术团队或合作伙伴支持下,搭建专属评估平台。

典型特征:

- 评估流程、表单、规则都可以可视化编排;

- 便于与内部已有系统整合,如项目管理、销售系统、工时系统等;

- 可以搭建评估引擎,支持不同业务线、不同序列使用差异化模型。

优势:

- 高度贴合业务实际,尤其适合项目制、矩阵制、多业态集团;

- 可将自评互评与业务数据深度融合(如项目成果、客户评分、质量指标);

- 随着业务演进,系统可持续迭代,不容易过时。

挑战与成本:

- 初始规划、设计与建设的周期相对较长,需要一定的IT治理能力;

- 对HR团队提出了更高的“系统思维”和“需求抽象能力”要求;

- 如果缺乏统一规划,容易出现“只懂局部、不看整体”的碎片化开发。

提醒:

这类方案适合管理成熟度与IT能力都达到一定水平的企业。否则,很容易在定制自由度中迷失,最终形成一个难以维护的复杂系统。

4. AI原生智能评估系统:追求持续反馈与深度洞察的进阶型方案

随着AI技术的发展,已经出现一类以“智能评估、持续反馈”为主打的系统:

- 通过自然语言处理分析文字评价的情绪和主题;

- 自动归纳团队优劣势;

- 为员工生成个性化发展建议。

对强调人才发展、领导力建设的大中型企业,这类系统颇具吸引力。

核心能力通常包括:

- 文本评价情绪与倾向分析;

- 模式识别(例如:某部门普遍被评价为“跨部门协作弱”);

- 为管理者生成可视化洞察和建议;

- 支持更高频率的轻量反馈(如项目结束反馈、季度反馈)。

前提与风险:

- 对数据质量和数据治理要求较高,自评互评如果本身质量不佳,AI再聪明也难以挖出真金;

- 员工和管理者对“被算法解析评价内容”的心理接受度存在差异,需要透明沟通与边界管理;

- 成本不只在购买系统,还在于训练组织学会使用洞察结果。

适用企业画像:

- 已经有较为成熟的绩效管理与反馈文化,希望进一步提升发展导向;

- 对关键人才、关键岗位的早期风险预警有明确诉求;

- 管理层愿意投入时间阅读、讨论系统生成的洞察报告。

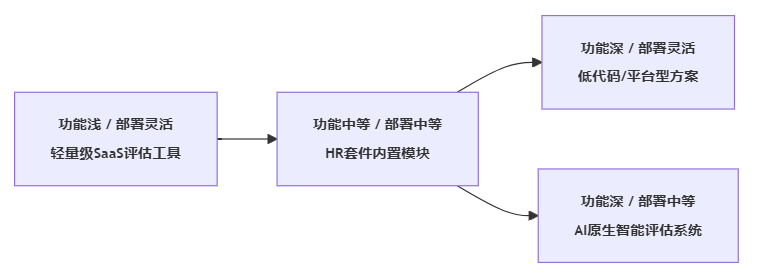

系统类型整体定位示意(图示)

下面用一个简单的象限图,帮助理解四类系统在“功能深度与部署灵活性”上的大致位置:

三、让“经济实用”真正落地:三大实施策略

很多企业买了看起来不错的系统,却发现落地效果一般,根本不在于系统便宜不便宜,而在于实施策略是否匹配企业现状。本模块的核心观点是:降本增效必须贯穿“设计—部署—运营”全周期,而不是只盯上线那一刻。

1. 设计阶段:用80/20法则聚焦关键人群与核心场景

在项目启动时,常见的一个误区是:“既然买了系统,就让所有人、所有流程都上系统”。结果是流程极其复杂,培训成本高,员工体验差,最后不得不简化回退。

更推荐的路径是:用80/20法则划定“首批重点人群与关键场景”,例如:

- 先在中高层管理者、关键技术/业务岗位试行360度评估;

- 对一般岗位,保留简化版的自评+上级评,互评只在必要岗位设置;

- 对业务线差异特别大的集团,可先选取1–2个组织作为代表性试点。

这样做有几个好处:

- 系统配置复杂度可控,HR团队有余力打磨细节;

- 管理者可以更集中地体验反馈带来的价值;

- 为后续推广积累内部“成功故事”和使用经验。

2. 部署阶段:用灰度发布验证ROI,而不是“一键全国上线”

在大中型企业,跨区域、跨业务线的全面上线,往往意味着极高的沟通与培训成本。更稳妥的方式是分阶段、分批次灰度发布:

- 选择试点部门/业务单元

- 条件:管理者态度积极、业务节奏适中、有代表性。

- 设计清晰的评估目标和衡量指标

- 如:参与率、填写质量(空洞评价占比)、绩效面谈落实率等。

- 在一个或两个绩效周期内,观察试点效果

- 汇总定量、定性反馈,评估系统与流程设计的优缺点。

- 据此优化配置,再逐步推广至更多部门。

可以用一张简化表格,来对比某制造企业在试点前后评估效能变化(示意):

| 指标 | 试点前(人工/旧系统) | 试点后(新系统+优化流程) |

|---|---|---|

| 评估周期平均耗时 | 较长 | 明显缩短 |

| HR人工汇总与追踪工作量 | 高 | 大幅下降 |

| 员工自评/互评参与率 | 中等 | 有所提升 |

| 绩效面谈完成率 | 偏低 | 明显提高 |

不需要精确到某个百分比,只要能用事实说明“新系统+新流程”的改善趋势,就足以支撑决策层做进一步投资或推广。

3. 运营阶段:用AI和规则替代重复劳动,把HR从“算分员”解放出来

系统上线后,如果HR仍然需要大量时间做提醒、汇总、基础分析,那么“经济实用”这个目标仍然没有实现。运营阶段可以重点关注以下几个自动化方向:

- 自动提醒与预警

- 未完成自评/互评的人员,系统按节点自动发送提醒;

- 某一部门或角色参与率异常偏低时,系统触发预警,提示HR跟进。

- 自动生成多维报表

- 部门、序列、职级维度的得分分布;

- 自评与他评差异情况;

- 关键能力项的整体强弱。

- 基于规则或AI的“异常识别”

- 某员工具有极高的“自评-他评差距”;

- 某部门存在明显的“打分宽松/严格”倾向;

- 文字评价中出现频率极高的负面主题。

这些能力的目标并不是要代替管理者,而是把HR从大量机械的、重复的数据整理中解放出来,把时间用在更有价值的分析和辅导上。

四、警惕“看上去很实用”的三大陷阱

不少企业反馈:“系统功能挺实用的,但用了一两轮之后,大家又开始觉得没什么价值。”这往往不是系统不会用,而是陷入了几个典型陷阱。本模块希望起到踩坑预警的作用,帮企业省下一些学费。

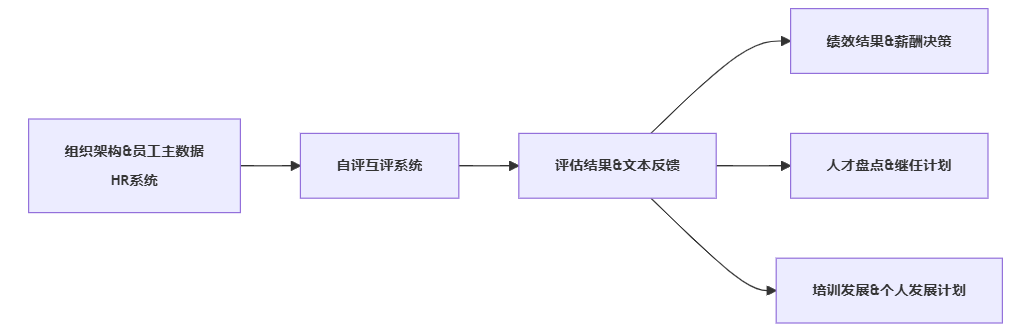

1. 数据孤岛陷阱:有了系统,却依然无法支撑人才决策

如果自评互评系统只是一套孤立的打分工具,而没有与人力资源主数据、业务数据打通,其价值往往停留在“完成一次考核流程”这一层 surface。

缓解方式是,在选型和实施初期就画清楚关键数据流转路径,例如:

如果在架构上,评估结果很难流入绩效、薪酬、人才发展等模块,那么系统再好,也只是一个“高档表单收集器”。

2. 员工抵触陷阱:技术没问题,文化没准备好

不少大中型企业在引入较复杂的自评互评系统时,都会碰到员工的三个常见反应:

- “又来一套系统,要学一堆操作。”

- “说是匿名互评,真的安全吗?”

- “写了那么多意见,最后也没人看,干脆敷衍。”

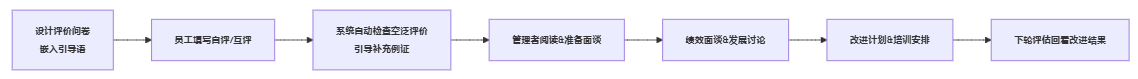

这说明,单靠工具不可能自动带来高质量反馈文化。需要在制度和引导上同步设计:

- 匿名与实名的动态平衡

- 对敏感度高的评价(如对上级的反馈),可更倾向匿名;

- 对发展导向的反馈(如对同事的建议),可适度鼓励实名或半实名。

- 反馈质量的引导与培训

- 给出好反馈的示例(具体、可执行、聚焦行为而非性格);

- 在系统中嵌入评价提示,如“请尽量举1–2个具体事例”。

- 让员工看到反馈“被用起来”的证据

- 在绩效面谈、团队会议中引用互评结果;

- 提示某些培训、辅导项目是根据反馈结果设立的。

可以用简单的流程图梳理一个“反馈引导流程”:

关键在于:让员工感受到“我写的内容,确实影响了管理决策和个人发展”,抵触情绪才会逐步下降。

3. 评估形式化陷阱:只看分数,不看对话

很多组织的评估工作,到最后只剩下一个数字:

A员工:S,B员工:A,C员工:B+……

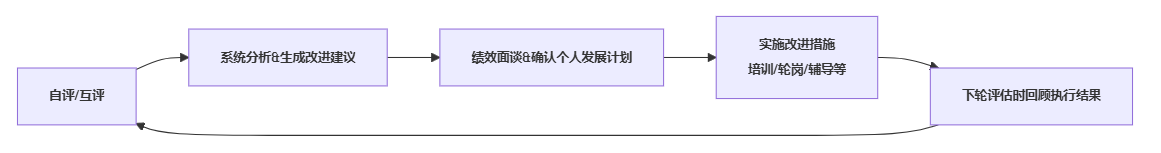

这种“数字崇拜”的结果,是自评互评系统沦为“打分机器”,而不是“对话平台”。要避免形式化,有两个关键动作:

- 把评估结果与个人发展计划(IDP)关联起来

- 系统支持在评估结束后,为每位员工生成一份“改进建议草稿”;

- 管理者与员工在面谈时,共同确认2–3项明确的改进行动。

- 在下轮评估中,回看上轮承诺与实践

- 例如,系统自动提醒管理者:“该员工上期约定了3项改进目标,请在评价时关注进展情况。”

- 这样,自评互评才不只是一次性事件,而是一个连续的改进循环。

我们可以用一个简单的闭环示意:

结语:回到那个问题——大中型企业到底适合什么自评互评系统?

文章开头我们提出那个问题:“大中型企业适合使用什么自评互评系统?” 走完一圈分析后,更清晰的答案大概是:

- 适合与否,首先取决于匹配度,而不是高大上程度。

- 基础能力必须可靠;

- 总拥有成本要可控;

- 扩展性要能支撑未来2–3年的管理演进。

- 与其纠结单一产品,不如先判断适合哪一类系统路径:

- 数字化起步期:轻量级SaaS工具,先把流程跑通、文化跑顺;

- 已有HR系统:优先用好套件内置模块,减少系统碎片;

- 业务高度定制:考虑低代码/平台型方案,搭建评估工坊;

- 发展导向成熟:引入AI原生智能评估系统,探索持续反馈与深度洞察。

- 真正的“经济实用”,来自三方面的共同作用:

- 理论上,坚守“数据驱动—员工体验—组织发展”的三角平衡,而不是只看某一个维度;

- 实践上,采用“小步快跑”的实施策略,以试点和灰度发布验证价值;

- 演进上,选一个可以长大的系统,而不是每隔几年重来一次。

对HR从业者和管理者而言,下一步可以马上行动的,是三件事:

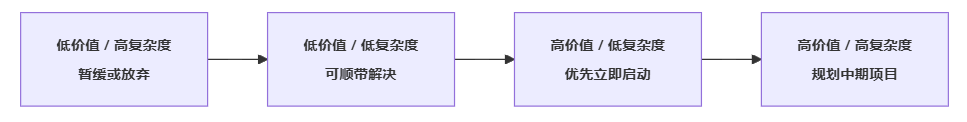

- 用一张“价值—复杂度矩阵”列出本企业的潜在需求场景,评估哪些是高价值低复杂度的优先项;

- 对照文中四类系统,判断自己当下更适合哪一路线,并据此缩小选型范围;

- 在与供应商讨论时,不只看演示界面,更要围绕TCO、扩展性和落地策略,问到足够多的“怎么做”“做成什么样算成功”。

最后,用一个简化的决策矩阵,帮你梳理需求优先级(示意):

如果能在这个矩阵上,把自评互评相关的需求一一落位,再去看市场上的系统和方案,你会发现:“适合我们的大中型企业用的经济实用自评互评系统”这件事,并没有想象中那么玄乎,只是需要更清醒、更专业的判断。